浏览器端本地运行语言模型 = Transformers.js + WebGPU + Phi-3

浏览器端本地运行语言模型 = Transformers.js + WebGPU + Phi-3

罗布斯# 介绍

Phi-3-mini-4k-instruction ,这是一个 38.2 亿的参数 LLM,它针对 Web 上的推理进行了优化。下载后,模型(2.3 GB)将被缓存,并在您重新访问页面时重用。

所有内容都 直接在浏览器中运行 ,这意味着您的对话不会发送到服务器。🤗甚至可以在模型加载后 断开与互联网的连接 !

# 使用步骤

进入网址:点击进入

点击: load model, 大约也就 2 个 G 多一点,下载完成后就可以正常使用啦。

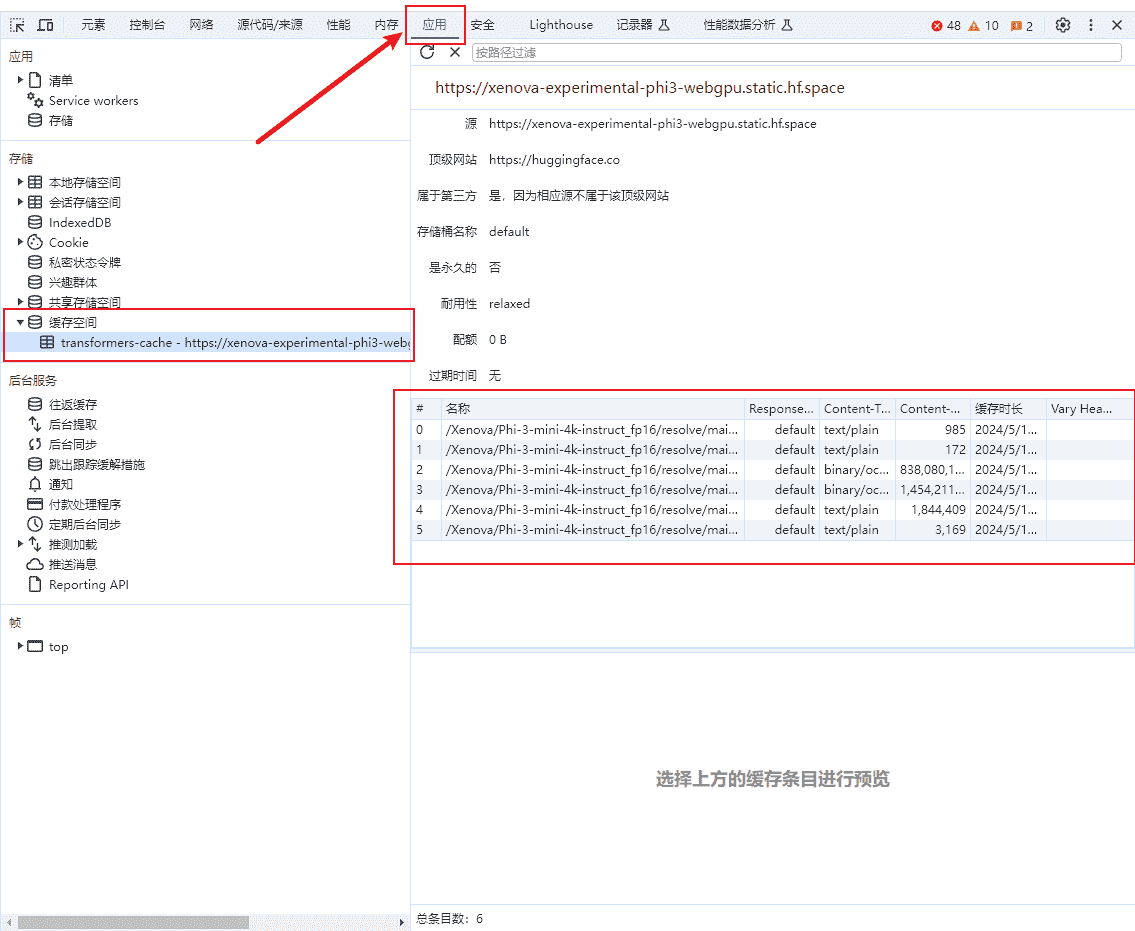

大模型被缓存到浏览器里(按 F12 查看)

# 相关链接

评论

匿名评论隐私政策

TwikooGitalk

✅ 你无需删除空行,直接评论以获取最佳展示效果